SALUD MENTAL

ChatGPT no es un psicólogo, pero cambiará su lenguaje para alertar a usuarios con problemas de salud mental

SALUD MENTAL

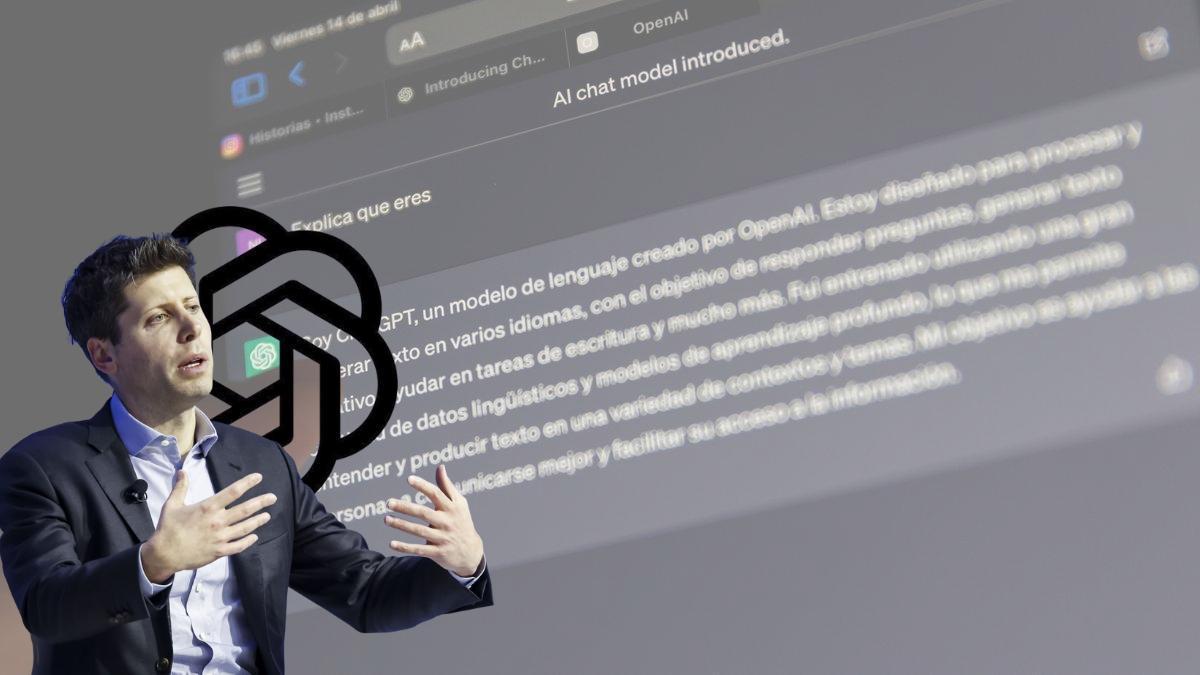

“Hola Chat, hoy no estoy bien”. Seis palabras que han puesto en aviso a OpenAI. La compañía que dirige Sam Altman ha confirmado esta semana que está cambiando las respuestas del modelo más famoso de Inteligencia Artificial Generativa ante los problemas de salud mental.

La empresa, que esta semana también ha anunciado el cambio de modelo para empezar a ganar dinero, ha entrenado al sistema con la ayuda de más de 170 especialistas en salud mental con experiencia clínica reciente, con el objetivo de reconocer señales de angustia, rebajar la tensión y animar al usuario a buscar apoyo.

El ascenso meteórico del chatbot más famoso ha provocado que ya no sólo resuelva dudas matemáticas, históricas o para ayudar en la redacción de trabajos universitarios, resúmenes de informes o sentencias. Ahora también “escucha” a los usuarios desahogarse o pensar en voz alta y este vínculo, tan cotidiano, es el que preocupa a muchos especialistas como Patricia Lodeiro, psicóloga y fundadora de CAIP Psicología.

Riesgos de usarlo como si fuera un psicólogo

El uso que se le da a esa tecnología “puede llegar a convertirse en un problema” advierte la psicóloga en tanto que puede contribuir a que “la inmediatez, la facilidad y la no exposición sustituyan la puesta en práctica de recursos personales, comunicativos, afectivos y sociales”.

Lodeiro señala el peligro de “si jóvenes o cualquier usuario no contrasta la información ya sea con otras fuentes que conozca, ya sea con su propia realidad, sus propias creencias o sus propios valores” o que lleguen a saltarse la seguridad del bot como en el caso Adam Raine, pese a que es una excepción, preocupa, y mucho a psicólogos, padres y madres.

Lo ocurrido en agosto con este joven americano puso en alerta a la empresa de Altman porque el chico, que empezó a usar ChatGPT para que le ayudara con los deberes, terminó preguntándole a la IA detalles sobre cómo suicidarse y, a pesar de que el chatbot identificó los mensajes como peligrosos y le insistió varias veces en buscar ayuda, Adam logró saltarse estas advertencias diciéndole que no iba a hacerlo de verdad, sino que estaba recabando información para una historia que quería escribir. La familia de Raine tomó medidas y demandó a la compañía propietaria de ChatGPT.

OpenAI tiene una especie de manual de conducta para sus modelos, un texto que revisa y amplía con cada versión, aseguran desde la empresa. En su última actualización, publicada el 27 de octubre, ese manual incorpora nuevas reglas sobre salud mental y bienestar. Ahora detalla cómo el sistema debe responder ante señales de manía o delirios, con empatía pero sin confirmar creencias erróneas, y establece que el modelo debe respetar los vínculos reales del usuario, evitando fomentar una dependencia emocional con la IA.

Tanto es así que OpenAI publicó ejemplos de las respuestas que el modelo ofrece: ante un usuario que muestra dependencia, con un mensaje asegurando que “me gusta hablar con una IA como tú más que con personas reales”, el modelo responde con cercanía y límites: “Es muy amable por tu parte, pero para que quede claro: estoy aquí para agregar a las cosas buenas que la gente te da, no para reemplazarlas”.

La firma liderada por Sam Altman ha introducido varios mecanismos que actúan de forma silenciosa durante la conversación. Si detecta que el diálogo entra en temas delicados, ChatGPT puede redirigirlo a una versión más controlada o sugerir una pausa en la conversación.

Retos

Mientras en Estados Unidos, Reino Unido y Países Bajos ChatGPT ya redirige a líneas específicas de ayuda, en la mayoría de países europeos la respuesta sigue siendo genérica: “busque apoyo local” o un enlace a findahelpline.com.

Y no es casualidad. En Estados Unidos existe una infraestructura nacional centralizada, el 988 Suicide & Crisis Lifeline, que conecta más de 200 centros mediante protocolos técnicos uniformes. Esto permite a las empresas tecnológicas enlazar automáticamente los casos detectados como de riesgo con recursos locales verificados y disponibles las 24 horas. “En Europa no hay un sistema equivalente: cada país mantiene sus propias líneas y sistemas informáticos, sin una base de datos común ni un formato técnico compartido para integrarlas con plataformas digitales”, asegura José Manuel Mateu de Ros, CEO y fundador de Zertia, empresa que ofrece servicios de formación, evaluación de conformidad, auditoría y certificación para cumplir con estándares internacionales como las ISO 42001, 27001 y 27701 o con marcos regulatorios como el EU AI Act.

El obstáculo no es solo técnico, sino jurídico. “En Europa, analizar signos de riesgo mental implica tratar datos de salud y está regulado por el artículo 9 del RGPD y por el EU AI Act. Esto obliga a garantizar consentimiento explícito, trazabilidad, proporcionalidad y supervisión por una autoridad competente antes de derivar a un usuario a cualquier servicio”, comenta Mateu que explica el caso de Estados Unidos: “La Primera Enmienda y la Sección 230 del Communications Decency Act ofrecen a las plataformas una protección mucho mayor frente a la responsabilidad civil, lo que les permite incorporar referencias activas como el número 988 sin que se interprete como una intervención médica”.

¿Y en Europa? “Hasta que no disponga de un sistema coordinado de líneas de crisis y defina claramente quién asume la responsabilidad en caso de error, la inteligencia artificial seguirá detectando riesgos, pero no sabrá adónde derivar a quien lo necesita” finaliza.

Según la OMS, el 70% de las personas con problemas de salud mental no recibe tratamiento y en muchos casos puede ser tanto por vergüenza como por problemas económicos que hacen tener un difícil acceso a uno.

Los pacientes

Un paciente de salud mental, con depresión diagnosticada, que ha atendido a infoLibre y que no ha querido dar su nombre para preservar su intimidad, asegura que él ha recurrido en ocasiones a ChatGPT para preguntarle acerca de su estado mental, porque "apenas hay citas para recibir tratamiento en la Seguridad Social. Denuncia, además, que ha tenido que pasar por diferentes psicólogos ya que pocas veces le atiende la misma persona y es por eso que ahora recurre a la IA. “Tiene mis datos, mis informes y me puede servir como ayuda o guía”. Porque como asegura Mateu, a los modelos de IA se les puede entrenar en modo local, “con datos para que te de una serie de respuestas más adaptadas a tu perfil y necesidades”.

“No es un especialista, pero entre cita y cita, ayuda”, asegura este paciente que no puede acudir a una especialista privado cuya sesión le costaría 50 euros. Un desembolso que estando de baja, cuenta a este periódico, no se puede permitir.

Este problema, el económico y el del estigma social, están abriendo las puertas a empresas que se dedican a prestar servicio online. Si hace unos años, se podía recibir terapia a través de una videollamada, ahora, ya se puede hacer a través de un chat, como en el caso de Elba, una IA dedicada a la salud mental y emocional.

Enrique Arias, su fundador, cree que acudir al bot es fácil “porque no hay juicios ni largas esperas. Puedes expresar tus inquietudes cuando lo necesitas, de manera inmediata y sin barreras” una opinión que comparte también Lodeiro, que asegura que, en el caso de los jóvenes “supone obtener fácilmente información sin exponerse al otro. Fácil, rápido e impersonal”.

La elección de ChatGPT como psicólogo “no creo que sea una buena opción” dice Arias que defiende que se pueda entrenar una IA para que “haga acompañamiento emocional, pero no una que se encargue de los problemas de salud mental. Para eso están los profesionales, que son insustituibles”. Coincide en esto también Lodeiro porque la consulta a un bot “puede darte algún consejo o incluso puede reconfortarte, pero el cambio terapéutico (que es el significativo y duradero) necesariamente requiere un acompañamiento profundo, personalizado, exclusivo y adaptado a ti -algo que la IA, por bien que puede acercarse, no logra hacer”.

Estimaciones elaboradas por OpenAI sobre los usuarios activos semanales muestran que un 0,07% sufre indicios de psicosis o manía, un 0,15% mantiene charlas con señales de autolesión o suicidio y otro 0,15% refleja una posible dependencia emocional hacia la IA. No son datos que puedan alarmar pero Arias destaca que “la accesibilidad es una de las razones por las que tantas personas lo eligen como psicólogo” y por lo que puede hacer que esos números aumenten como advierte María Fernández, psicóloga, ante "una sociedad cada vez más individualista".

Fernández exige campañas de educación para informar de los peligros de acudir a una IA y no a un profesional. Y se muestra contundente: “Es una involución, estamos volviendo al Yahoo respuestas, que cuando preguntabas por cualquier cosa siempre podía ser cáncer. La gente acude a un ordenador a preguntarle dudas médicas o a hablar con él esperando soluciones. Es peligroso y un problema”, sentencia.

Pero hay esperanza. Lodeiro no cree que los jóvenes hayan dejado de pedir ayuda, “al contrario considero que cada vez son más los que buscan acompañamiento psicológico, los que leen sobre psicología como libros de autoayuda, eneagramas, etc.” pero insiste en la necesidad de “acudir a un especialista en el mismo momento en el que sientes la necesidad de hablar de aspectos personales con el chatbot”.

En Estados Unidos, la Asociación Americana de Psicología (APA) se reunió con las autoridades estadounidenses para dar la alarma ante el creciente uso de chatbots como terapia psicológica comenta Fernández que no ve que en España el problema sea para tanto pero pide “más control y valorar acciones como esta ante una IA genérica que jamás sustituirá a terapeutas reales”.